Escrito por Kanijo en Física

Una oportuna entrevista con el físico Sean Carroll sobre cómo nuestro viaje de ida desde el pasado hacia el futuro está entrelazado con la entropía y el origen del universo.

Los físicos a menudo describen el tejido del universo en el que habitamos como un espacio-tiempo de cuatro dimensiones, con tres dimensiones espaciales y una temporal. Pero mientras que pasamos nuestros días viajando por el espacio en la dirección que deseamos (siempre que la gravedad y los obstáculos sólidos lo permitan), el tiempo nos empuja, queramos o no, a lo largo de una única dirección predeterminada del tiempo: hacia el futuro.

Esta es la flecha del tiempo — la vida nos lleva desde el pasado, a través del presente, hacia el futuro. El argumento de Back to the Future (Regreso al futuro) trata de esto, aunque nadie sabe cómo invertir la flecha – cómo movernos hacia atrás en el tiempo – y las paradojas lógicas que darían como resultado de tal viaje al pasado que nos colocarían, en el mejor caso, en una situación peliaguda. (Gracias a la predicción de la relatividad especial llamada dilatación temporal, el viaje al futuro lejano es relativamente fácil: simplemente muévete rápido, realmente rápido).

En su nuevo libro, From Eternity to Here (De la eternidad a aquí) (Dutton, 2010), el físico teórico Sean Carroll del Instituto Tecnológico de California se propone explicar por qué la flecha del tiempo sigue adelante inexorable en una dirección. Expandiendo los conceptos de su artículo de junio de 2008 para Scientific American, Carroll defiende la necesidad de casar tres ideas aparentemente dispares: tiempo, entropía y cosmología.

La entropía, que en términos comunes es la medida del desorden de un sistema, aumenta con el tiempo, tal y como dicta la segunda ley de la termodinámica. Para ilustrar el inexorable crecimiento de la entropía, Carroll nos lleva a la mesa del desayuno – no puedes des-revolver los huevos, señala, y no se puede des-remover la leche del café. Estos sistemas invariablemente llevan a configuraciones desordenadas, o de alta entropía. Cada uno de estos ejemplos muestra cómo el continuo crecimiento de la entropía llena el mundo de procesos irreversibles que dividen el pasado del futuro: Hacer una tortilla o mezclar leche en una taza de café son eventos que funcionan sólo en una dirección temporal.

Pero, ¿por qué debería incrementarse siempre la entropía? Aquí es donde Carroll se vuelve hacia la cosmología, la cual debe explicar por qué se inició el universo en un estado de insólita baja entropía. Hablamos con el físico sobre su nuevo libro y los retos de presentar física de vanguardia a una audiencia amplia.

¿Qué suscita tanto interés por el tiempo? Para un observador simplista es algo que simplemente pasa y con el que no podemos hacer nada; no cambia.

Hay dos cosas que me inspiraron para escribir el libro. Una es que el tiempo es algo que nos es familiar. Todos lo usamos – no tenemos problemas en leer un reloj. Pero entonces, cuando se actúa como un buen científico o filósofo y se le intenta dar sentido, surge un problema: Las leyes fundamentales de la física tratan el pasado y el futuro como si fuesen exactamente iguales, mientras que el mundo no lo hace. Hay una gran diferencia — el pasado ya sucedió, y el futuro está aún por llegar. Por lo que estaría bien reconciliar eso. Ése es el problema de la flecha del tiempo en el que se ha pensado durante al menos los últimos dos siglos.

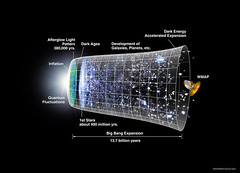

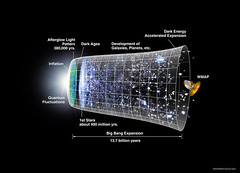

Creo que es un problema interesante e importante, y es tan bueno para escribir sobre él como cualquier otro. Pero hay algo que creo que hace de este problema algo especial, y es que la respuesta a por qué el pasado es diferente el futuro, sea cual sea su final, no trata sólo de lo que sucede aquí mientras estamos hablando, conforme pasa el tiempo en nuestras vidas cotidianas. Está íntimamente conectado con todo el universo – con lo que sucedió en el Big Bang, con las condiciones especiales en las que se inició nuestro universo.

Una comprensión total de lo que sucede en nuestras vidas cotidianas tiene que tener en cuenta lo que sucedió en el Big Bang. Y no sólo es que sea intrínsecamente interesante y algo divertido en lo que pensar, sino también un misterio al que no se ha prestado mucha atención por parte de los científicos que trabajan en él; está un poco subestimado. Estamos tan lejos de saber la respuesta que no pensamos mucho sobre eso. Por lo que quiero llevar la atención a esta conexión entre la flecha del tiempo y la cosmología, tanto a los lectores cotidianos como a mis amigos científicos. Creo que es algo que deberíamos realmente tener en mente como uno de los misterios fundamentales que afronta la ciencia moderna.

Como lector cotidiano, aprecio mucho las citas introductorias de los capítulos desde Annie Hall, Vladimir Nabokov, o Dos tontos muy tontos. ¿Qué reto supuso tratar de mantener el libro como algo accesible y divertido?

Lo intenté con todas mis fuerzas, y creo que tuve éxito en algunos lugares más que en otros. Gran parte del material no era exactamente en lo que yo trabajaba, por lo que tuve que aprender mucho sobre un montón de cosas de las que era apenas consciente. En realidad creo que lo hice mejor haciendo esas secciones animadas, interesantes y accesibles que las secciones que comprendía mejor. Debido a que sabía que tenía que sentarme y pensar muy profundamente sobre ello; no pude dar mi charla habitual.

Las buenas noticias son que, excepto por unas pocas cosas sobre mecánica cuántica y el multiverso, la mayor parte de ideas básicas son bastante captables. No son drásticamente abstractas; no tenemos que trabajar en dimensiones superiores o cosas como esas. Puedes ver las ideas básicas de las que estamos hablando trabajando por sí mismas en la vida cotidiana.

Soy un convencido de que la ciencia es parte de algo cultural mayor. La ciencia no es todo por sí misma. Por lo que definitivamente quiero dar la sensación de que cuando pensamos sobre el universo y el espacio y la experiencia y la memoria y el libre albedrío y todas esas cosas de las que hablo en el libro, son tanto ciencia como nuestras vidas cotidianas y la cultura en la que vivimos, por lo que ¿por qué no divertirnos y unirlas?

Volviendo a la ciencia por un momento, ¿cómo interviene el concepto de entropía con la flecha del tiempo?

Bien, creo que la gente probablemente haya escuchado la palabra entropía. Aumenta; esa es la segunda ley de la termodinámica. Tienes ese famoso – al menos famoso entre los científicos — episodio con [el novelista y físico inglés] C. P. Snow, donde trataba de convencer a la gente de que no deberían ser sólo ilustrados en literatura sino también en ciencia. Y el ejemplo que elige Snow como algo que todo el mundo debería conocer es la segunda ley de la termodinámica, la ley que dice que la entropía se incrementa.

Y esto es cierto, y creo que es un gran ejemplo, pero lo que pienso que en realidad está subestimado es todo lo que concierne a la flecha del tiempo – lo que pensaríamos sobre “cómo funciona el tiempo”, el hecho de que el pasado está escrito en piedra mientras que el futuro aún puede alterarse – todo debido a la entropía. El hecho de que puedas recordar ayer pero no mañana es debido a la entropía. El hecho de que siempre naces joven y mueres viejo, y no al revés como Benjamin Button — es todo debido a la entropía. Por lo que creo que la entropía no es apreciada como algo que tiene un papel crucial en cómo pasamos por nuestra vida.

Usted tiene una especie de momento de sinceridad en el libro cuando habla sobre un veterano físico al que no nombra que tuvo algunas quejas con sus teorías sobre el tiempo y la segunda ley.

Su objeción era con la idea de que la comología tenía algo que ver.

La siguiente frase es totalmente cierta: Para comprender la segunda ley de la termodinámica, o cómo funciona la flecha del tiempo en nuestras vidas cotidianas, no tenemos que hablar sobre cosmología. Si tomas un libro de mecánica estadística, no habrá nada de cosmología en absoluto. Por lo que sería incorrecto decir que tenemos que comprender el Big Bang para usar la segunda ley de la termodinámica, para saber cómo funciona. El problema es que para comprender por qué existe, se requiere un conocimiento de la cosmología y lo que sucedió en el Big Bang.

Una vez asumes que el universo tiene una entropía baja por la razón que sea, todo lo demás se sigue, y sobre esto es sobre lo que siempre hablamos en los libros de texto. Pero vamos a ser un poco más ambiciosos que eso. Queremos comprender por qué era de esta forma – ¿por qué la entropía era ayer menor que hoy?

Comprender por qué la entropía era menor ayer requiere de la cosmología. Y creo que si te sientas y lo piensas con cuidado no hay ninguna duda de que esto es cierto, aunque mucha gente no lo acepta aún.

Si se toma esta aproximación y se mira al tiempo desde una perspectiva cosmológica, ¿qué era esta condición de baja entropía en el pasado? ¿Qué aspecto tendría?

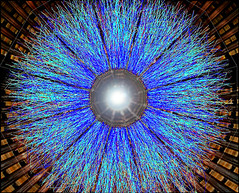

No aprendemos nada sobre el inicio del universo haciendo esta observación. Ya sabemos qué aspecto tenía el inicio del universo. Era liso, se expandía muy rápidamente, era un estado denso y caliente, y había una gran cantidad de materia en el universo. Ahora, esta parece que era una configuración del universo de entropía muy baja, y ese es el misterio. Por lo que no se trata de aprender qué aspecto tenía el universo joven, algo que ya sabemos – se trata de que al intentar explicarlo, al tratar de llegar a una teoría, sea la inflación o el universo cíclico o un gran rebote, no se ha tenido éxito al explicar los inicios del universo a menos que expliques por qué tenía entropía baja. Y puedo pensar en un tremendo número de teorías cosmológicas contemporáneas que fallan tal requisito; dan un paso lateral para rodear la cuestión en lugar de abordarla frontalmente.

¿Estas teorías hacen predicciones que puedan ser probadas basándonos en nuestra comprensión del tiempo y la entropía?

Aún no. Nos encantaría hacerlo. Todo lo que puedo decir es que espero que lo hagan. Hablo de este tema en el epílogo del libro.

Por una parte, si estas ideas no se conectan con las cosas que observamos, es inútil hablar de ellas. Pero esto no es lo mismo que decir que, debido a que no podemos conectarlas actualmente con predicciones observables, es inútil hablar de ellas. Son parte de un cuadro mucho mayor – tenemos que comprender cómo se unen la mecánica cuántica y la gravedad mucho antes de que podamos decir definitivamente que tenemos la respuesta correcta a estas cuestiones.

Autor: John Matson

Fecha Original: 7 de enero de 2010

Enlace Original

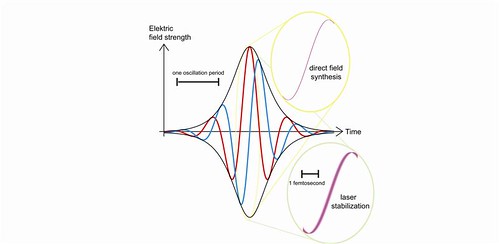

Se ha logrado desarrollar una fuente del todo nueva de luz, descrita como un condensado de Bose-Einstein integrado por fotones. Hasta hace poco, todo experto lo habría considerado imposible.

Se ha logrado desarrollar una fuente del todo nueva de luz, descrita como un condensado de Bose-Einstein integrado por fotones. Hasta hace poco, todo experto lo habría considerado imposible.

Un nuevo experimento propuesto por físicos en el Instituto Nacional estadounidense de Estándares y Tecnología (NIST) podría hacer posible que los científicos comprobasen con una precisión sin precedentes los efectos de la gravedad a muy cortas distancias, en una escala espacial en la que podrían detectarse nuevos y exóticos detalles del comportamiento de ésta

Un nuevo experimento propuesto por físicos en el Instituto Nacional estadounidense de Estándares y Tecnología (NIST) podría hacer posible que los científicos comprobasen con una precisión sin precedentes los efectos de la gravedad a muy cortas distancias, en una escala espacial en la que podrían detectarse nuevos y exóticos detalles del comportamiento de ésta

Los electrones son partículas elementales con carga negativa. Forman una cubierta alrededor de los núcleos de átomos e iones. Esto o algo similar es lo que se puede leer en los libros de texto. Sin embargo, pronto esta información podría tener que ser modificada. La razón es que muchos físicos consideran que los electrones pueden tener un momento dipolar eléctrico permanente. Un modo de comprobarlo está siendo ahora desarrollado

Los electrones son partículas elementales con carga negativa. Forman una cubierta alrededor de los núcleos de átomos e iones. Esto o algo similar es lo que se puede leer en los libros de texto. Sin embargo, pronto esta información podría tener que ser modificada. La razón es que muchos físicos consideran que los electrones pueden tener un momento dipolar eléctrico permanente. Un modo de comprobarlo está siendo ahora desarrollado Las ondas de ultrasonido de alta intensidad que viajan a través de un líquido dejan burbujas en su estela. Bajo las condiciones correctas, estas burbujas implosionan de modo espectacular, emitiendo luz y alcanzando muy altas temperaturas, en un fenómeno que se conoce como sonoluminiscencia. Los científicos han observado implosionar a burbujas sometidas a temperaturas tan altas que el gas dentro de ellas se ioniza formando plasma, pero cuantificar con la debida precisión la temperatura y la presión ha sido poco viable hasta ahora

Las ondas de ultrasonido de alta intensidad que viajan a través de un líquido dejan burbujas en su estela. Bajo las condiciones correctas, estas burbujas implosionan de modo espectacular, emitiendo luz y alcanzando muy altas temperaturas, en un fenómeno que se conoce como sonoluminiscencia. Los científicos han observado implosionar a burbujas sometidas a temperaturas tan altas que el gas dentro de ellas se ioniza formando plasma, pero cuantificar con la debida precisión la temperatura y la presión ha sido poco viable hasta ahora Un equipo de investigadores cree haber abierto una puerta hacia un conocimiento más detallado de cómo el mundo cotidiano que captamos a través de nuestros sentidos emerge del etéreo mundo cuántico

Un equipo de investigadores cree haber abierto una puerta hacia un conocimiento más detallado de cómo el mundo cotidiano que captamos a través de nuestros sentidos emerge del etéreo mundo cuántico

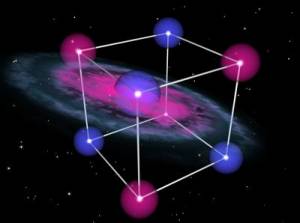

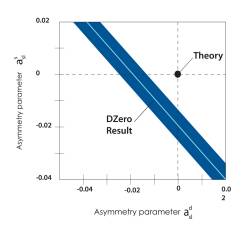

Unos científicos del programa internacional DZero en el Laboratorio del Acelerador Nacional Fermi (Fermilab), en Estados Unidos, han encontrado evidencia de una violación significativa de la simetría materia-antimateria en el comportamiento de partículas que contienen quarks Bottom, una vulneración que rebasa lo predicho en la teoría actual, el Modelo Estándar de la física de partículas

Unos científicos del programa internacional DZero en el Laboratorio del Acelerador Nacional Fermi (Fermilab), en Estados Unidos, han encontrado evidencia de una violación significativa de la simetría materia-antimateria en el comportamiento de partículas que contienen quarks Bottom, una vulneración que rebasa lo predicho en la teoría actual, el Modelo Estándar de la física de partículas

Se ha conseguido crear una estructura que actúa como un imán de un solo polo. Este logro técnico había sido perseguido, sin éxito hasta ahora, desde hace muchas décadas

Se ha conseguido crear una estructura que actúa como un imán de un solo polo. Este logro técnico había sido perseguido, sin éxito hasta ahora, desde hace muchas décadas Un equipo de científicos de Rusia y Estados Unidos ha detectado por vez primera al elemento superpesado conocido como elemento 117

Un equipo de científicos de Rusia y Estados Unidos ha detectado por vez primera al elemento superpesado conocido como elemento 117