Los computadores cuánticos pueden resolver en cuestión de instantes problemas que llevarían años a los ordenadores convencionales. Pero hasta el momento, estos computadores sólo existen en configuraciones experimentales de vanguardia en unos pocos laboratorios físicos.

Los computadores cuánticos pueden resolver en cuestión de instantes problemas que llevarían años a los ordenadores convencionales. Pero hasta el momento, estos computadores sólo existen en configuraciones experimentales de vanguardia en unos pocos laboratorios físicos.

Ahora, Elena Kuznetsova, investigadora de posdoctorado en el Departamento de Física de la Universidad de Connecticut (UConn), ha propuesto un nuevo tipo de computador cuántico que podría hacer que la tecnología estuviese un paso más cerca de convertirse en realidad.

“El principal entusiasmo en los computadores cuánticos”, dice Kuznetsova, “procede de su potencial capacidad para resolver ciertos problemas de forma exponencialmente más rápida que los ordenadores clásicos, tales como factorizar un número grande en sus número primos, lo cual nos permitiría romper códigos criptográficos. Estos problemas no pueden resolverse usando un ordenador clásico en un futuro previsible”.

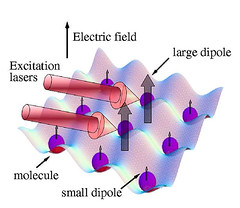

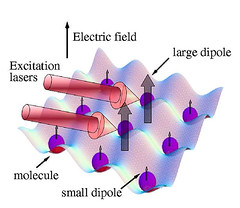

Los procesadores cuánticos aprovechan los principios de la mecánica cuántica, en la cual los objetos se comportan de forma distinta a escalas muy pequeñas de como funciona la materia a escalas mayores. Normalmente, sus procesadores codifican información en átomos individuales o moléculas hechas de dos átomos. Pero Kuznetsova y su grupo de investigación ha propuesto el primer sistema viable que usa tanto átomos como moléculas, aprovechando los beneficios de cada uno. Este sistema podría ser capaz de calcular más rápida y eficientemente que los procesadores cuánticos anteriores.

Kuznetsova y sus colegas en física, incluyendo al estudiante graduado Marko Gacesca y a los profesores Susanne Yelin y Robin Côté, informan de sus resultados en el ejemplar de marzo de la revista Physical Review A.

Como explica Yelin, hay varios componentes para la computación cuántica. El primer reto es crear un sistema que se controle lo bastante bien como para realizar cálculos, y otro es idear un dispositivo que informará de los resultados sin dañar el sistema. El computador cuántico más avanzado hasta la fecha está realizado con átomos neutros, en lo cual, dice Yelin, los físicos han pasado décadas trabajando y ahora pueden controlar en un grado muy fino. Estos átomos neutros no tienen carga eléctrica, y por tanto es muy difícil que interactúen entre sí. Esta dificultad frena la velocidad de los cálculos.

No obstante, en los últimos años, los científicos han descubierto moléculas polares – que contienen dos átomos con cargas iguales y opuestas – que podrían llevar a unos sistemas cuánticos de procesado más rápido debido a que la presencia de estas cargas opuestas anima a las moléculas a interactuar fuertemente entre ellas.

Pero esta diferencia en el comportamiento molecular es a la vez una gran solución y un gran problema, dice Yelin. Para ser útil, estas moléculas hiperactivas tienen que ser enfriadas a sólo unas pocas millonésimas de grado por encima del cero absoluto, lo cual las frena permite a los científicos controlarlas.

“Las moléculas en los estados cuánticos son muy frágiles”, dice Yelin. “Si las calientas, desaparecen. Si las pones demasiado cerca, desaparecen. Si las observas de la forma equivocada, desaparecen”.

La fragilidad de estas moléculas también supone otro problema: cuando se usan para informar de los resultados de un procesador cuántico, los científicos a menudo pierden el control de las mismas y los propios datos que han estado tratando de calcular se destruyen. Hasta el momento, los investigadores no han llegado a una buena forma de leer los datos de estas moléculas.

En su reciente artículo, el grupo de Kuznetsova ideó una forma de separar las moléculas en sus partes componentes de forma que los resultados del procesador pudiesen leerse a partir de los átomos individuales más fácilmente controlables. Usando lásers, dice Kuznetsova, fueron capaces de romper las moléculas sin comprometer los datos codificados en ellas.

“Dejamos que la molécula interactúe con una luz láser en una longitud de onda muy específica, o color”, dice. “Esto excita la molécula hacia otro estado excitado, a partir del cual podemos, con otra luz láser, separarla en dos átomos. Es una forma eficiente y no destructiva de mantener la información y leerla”.

Kuznetsova dice que cada parte de su idea es factible usando los métodos experimentales actuales, pero sólo para un conjunto generalizado de qubits — como se conoce a las unidades de información cuántica — todos a la vez. El siguiente paso hacia la construcción de un ordenador con moléculas polares, dice Yelin, es crear un sistema en el que los qubits puedan controlarse individualmente.

Yelin admite que su trabajo a veces puede parecer sobrenatural a los no especialistas, pero dice que no lo haría de otra forma.

“A primera vista, estas interacciones de luz y partículas parecen magia”, dice. “Estas moléculas polares son el pináculo de la óptica cuántica”.

Autor: Christine Buckley

Fecha Original: 15 de junio de 2010

Enlace Original

Los últimos bloques de direcciones del protocolo IPv4 que aún estaban disponibles en la IANA (Internet Assigned Numbers Authority) han sido entregados recientemente a los organismos regionales. Esta situación aumenta la amenaza de un posible agotamiento de direcciones.

Los últimos bloques de direcciones del protocolo IPv4 que aún estaban disponibles en la IANA (Internet Assigned Numbers Authority) han sido entregados recientemente a los organismos regionales. Esta situación aumenta la amenaza de un posible agotamiento de direcciones.

Un chip que realiza cálculos que no son del todo exactos podría a cambio procesar algunos tipos de datos miles de veces más eficientemente que los chips actuales

Un chip que realiza cálculos que no son del todo exactos podría a cambio procesar algunos tipos de datos miles de veces más eficientemente que los chips actuales Como un cubito de hielo en un día caluroso, la mayoría de los materiales se funden, es decir cambian del estado sólido al líquido cuando se calientan. Sin embargo, algunos materiales raros lo hacen a la inversa: se funden cuando se enfrían. Ahora, un equipo de investigadores del MIT ha descubierto que el silicio, el material más ampliamente usado para los chips de ordenador y las células solares, puede exhibir esa extraña propiedad de la “fusión retrógrada” cuando contiene altas concentraciones de ciertos metales disueltos en él

Como un cubito de hielo en un día caluroso, la mayoría de los materiales se funden, es decir cambian del estado sólido al líquido cuando se calientan. Sin embargo, algunos materiales raros lo hacen a la inversa: se funden cuando se enfrían. Ahora, un equipo de investigadores del MIT ha descubierto que el silicio, el material más ampliamente usado para los chips de ordenador y las células solares, puede exhibir esa extraña propiedad de la “fusión retrógrada” cuando contiene altas concentraciones de ciertos metales disueltos en él Un equipo de investigadores de la Universidad Estatal de Ohio ha demostrado un innovador dispositivo de memoria para ordenadores que utiliza el espín de los electrones para leer y escribir los datos

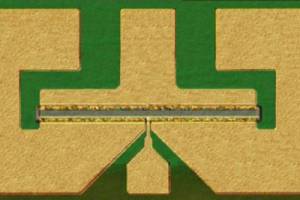

Un equipo de investigadores de la Universidad Estatal de Ohio ha demostrado un innovador dispositivo de memoria para ordenadores que utiliza el espín de los electrones para leer y escribir los datos